Dưới đây là bản phân tích “how it works + risk playbook” cho AI agents (tác nhân AI) — vừa kỹ thuật vừa thực dụng để triển khai trong doanh nghiệp.

1) AI agent hoạt động như thế nào?

Một agent điển hình gồm những “khối chức năng” sau:

- Nhận nhiệm vụ (Task Intake)

- Nhận yêu cầu ở dạng ngôn ngữ tự nhiên, ticket, hay event hệ thống.

- Chuẩn hoá → mục tiêu, ràng buộc, KPI, SLA.

- Lập kế hoạch (Planner)

- Mô hình LLM lập chuỗi bước (plan) và chọn công cụ cần dùng.

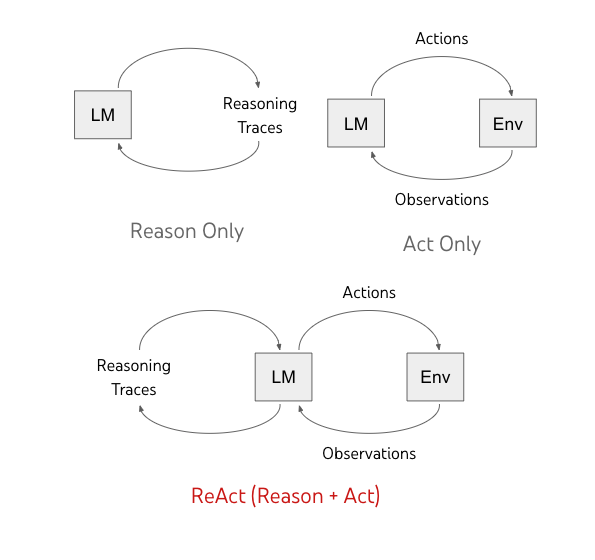

- Các phương pháp như ReAct (reason + act) cho phép mô hình vừa suy luận vừa hành động theo vòng lặp quan sát→suy luận→hành động, giúp giảm ảo giác khi cần truy xuất thông tin ngoài mô hình. (arXiv, Google Research)

- Gọi công cụ (Tool Use / API Calls)

- “Toolformer” cho thấy mô hình có thể tự học cách gọi API (khi nào gọi, truyền tham số gì) để dùng máy tính, tìm kiếm, dịch, lịch…, rồi chèn kết quả trở lại dòng suy luận. (arXiv)

- Bộ nhớ & ngữ cảnh (Memory)

- Bộ nhớ ngắn hạn (scratchpad) cho kế hoạch/bước trung gian; bộ nhớ dài hạn để lưu tri thức quy trình, FAQ, chính sách; vectordb để truy lục tài liệu nội bộ.

- Thực thi & kiểm định (Executor + Verifier/Critic)

- Thực thi từng bước kế hoạch; sau mỗi bước, cơ chế “self-check/critic” kiểm tra đầu ra trước khi tiếp tục hoặc dừng. Các nghiên cứu đánh giá đa-agent và agent-bench chỉ ra lỗi phổ biến nằm ở suy luận dài hạn, chốt nhiệm vụ quá sớm, và thiếu bước xác minh cuối. (OpenReview, arXiv)

- Điều phối & giám sát (Orchestrator/Guardrails)

- Hạn quyền (scoped credentials, RBAC), sandbox (không gian thử), rate-limit, allow/deny-list API, kiểm duyệt prompt/output, nhật ký kiểm toán (audit trail).

- Tuân thủ framework quản trị rủi ro (NIST AI RMF, ISO/IEC 23894) từ thiết kế đến vận hành. (NIST, NIST Publications, ISO)

2) Doanh nghiệp đang dùng agent cho gì?

Khảo sát EY US AI Pulse cho thấy ~1/3 lãnh đạo đã bắt đầu áp dụng công nghệ “agentic”; đa số dùng để tự động hoá các nhiệm vụ lặp lại, hỗ trợ khách hàng, nâng hiệu quả IT và an ninh mạng; nhưng mức “triển khai đầy đủ” còn thấp (≈14%). (Forbes, EY, CIJ Europe)

3) 10 rủi ro lớn khi phụ thuộc quá nhiều vào AI agents

- Ảo giác hành động (Actionable hallucination)

- Mô hình suy luận sai nhưng vẫn gọi API/thực thi, gây tác hại thực (xử lý ticket nhầm, huỷ đơn, đổi cấu hình…). Các benchmark ghi nhận điểm yếu ở suy luận dài hạn và hoàn tất nhiệm vụ quá sớm. Giải pháp: bắt buộc “task verification” & self-check cuối cùng; yêu cầu bằng chứng (tool outputs) trước hành động phá huỷ. (OpenReview, arXiv)

- Lỗi điều phối & vòng lặp vô hạn

- Planner kém → kế hoạch lệch; không có “loop guard” → vòng lặp API tốn chi phí. Giải pháp: giới hạn bước, watchdog, timeouts; “plan-then-execute” với checkpoint người thật.

- Tiêm nhiễm prompt & khai thác công cụ (Security)

- Prompt injection từ web/tài liệu; tấn công chuỗi công cụ (toolchain), escalations qua quyền API; rò rỉ dữ liệu. Sử dụng guardrails + kiểm soát quyền theo tác vụ, cách ly công cụ nhạy cảm, ATLAS của MITRE để mô hình hoá TTPs tấn công AI. (Sysdig)

- Tin tặc cũng dùng agent

- Cùng lúc phòng thủ dùng agent, kẻ tấn công dùng mô hình mã nguồn mở để do thám, tự động hoá khai thác lỗ hổng. Cần theo dõi bề mặt tấn công mới và cập nhật “playbook” phòng thủ. (Axios)

- Thoái hoá kỹ năng & sai lệch quyết định

- Nhân sự ỷ lại vào agent, giảm tư duy phản biện; nghiên cứu/khảo sát gần đây cũng cảnh báo tác động đến nhận thức/niềm tin nếu thiếu giám sát minh bạch. Xây “human-in-the-loop” đúng chỗ. (IT Pro)

- Trôi dạt mục tiêu (Objective drift)

- Agent tối ưu proxy (ví dụ rút ngắn thời gian xử lý) nhưng làm giảm chất lượng/tuân thủ. Cần KPI an toàn và kiểm định định kỳ.

- Tuân thủ & trách nhiệm pháp lý

- Ghi vết quyết định kém; khó giải trình (accountability). Áp dụng NIST AI RMF/ISO 23894 để xác định rủi ro, kiểm soát, và hồ sơ tuân thủ từ thiết kế đến gỡ bỏ (decommission). (NIST Publications, ISO)

- Chi phí âm thầm phình to

- Gọi mô hình/công cụ nhiều → đội chi phí nền; shadow agents mọc rải rác. Cần ngân sách/quotas, quan sát chi phí theo tác vụ.

- Khoá chặt nhà cung cấp & phân mảnh ngăn xếp

- Mỗi agent dùng SDK/adapter riêng, khó di trú. Dùng giao thức/chuẩn mở khi có thể; tách lớp điều phối với lớp model/tool.

- “Over-automation” các quy trình nhạy cảm

- Cybersecurity, pháp lý, tài chính: agent chỉ nên trợ giúp/đề xuất; quyết định cuối thuộc con người (đặc biệt theo khuyến nghị an toàn gần đây về mức độ tự chủ). (arXiv)

4) Kiến trúc vận hành khuyến nghị (high-level)

- Ingress: hàng đợi nhiệm vụ + phân loại rủi ro.

- Planner (LLM): sinh kế hoạch có “executable steps” + lý do.

- Tool Layer: API nhỏ, có scopes hẹp, secret vault, sandbox I/O.

- Verifier/Critic: kiểm chứng đầu ra quan trọng (schema, policy-as-code, unit tests cho hành động).

- Guardrails: prompt hygiene, content filters, allow/deny-list domain, loop guards.

- Observability: logs cấp token, trace tool-call, cost meter, evals liên tục.

- Governance: hồ sơ rủi ro theo NIST AI RMF/ISO 23894; review định kỳ. (NIST Publications, ISO)

5) 12 biện pháp kiểm soát thiết yếu (checklist triển khai nhanh)

- Human-in-the-loop cho tác vụ rủi ro vừa/cao; cờ “Require Review” trước hành động bất hồi phục.

- Policy-as-code: quy tắc tuân thủ được mã hoá, chạy tự động ở bước verifier.

- RBAC + Scoped Credentials: khoá quyền theo tác vụ/phiên; không chia sẻ token toàn cục.

- Sandbox & canary: chạy ở môi trường thử trước khi đẩy production.

- Prompt hygiene: tách dữ liệu không tin cậy; neutralize chỉ dẫn từ nội dung đầu vào.

- Allow/Deny-list Tool & Domain: chặn hành động ngoài phạm vi.

- Loop/time/budget guard: giới hạn vòng lặp, thời gian, chi phí.

- Evals liên tục: bộ bài test tác vụ thật (success, robustness, safety); theo dõi tỉ lệ “premature termination/verification failure”. (arXiv)

- Red-teaming theo ATLAS/ATT&CK: tập trận tấn công nhắm vào agent & toolchain. (Sysdig)

- Audit trail: lưu toàn bộ plan, suy luận tóm lược, tool-call, tham số, kết quả.

- Data governance: phân loại dữ liệu, PII handling, retention & masking.

- Vendor portability: trừu tượng hóa lớp model/tool (plugin interface) để tránh lock-in.

6) Khi nào NÊN và KHÔNG NÊN “agent hoá” quy trình?

- NÊN: quy trình lặp lại, logic rõ, có API đáng tin, có thể xác minh kết quả bằng tiêu chí định lượng.

- KHÔNG NÊN (hoặc chỉ “copilot”): quyết định pháp lý, tài chính, bảo mật nhạy cảm; quy trình thiếu tín hiệu xác minh khách quan.

7) Lợi ích & thực tế hiện tại

- Lợi ích: giảm việc vặt, tăng tốc hỗ trợ khách hàng/IT, phòng thủ chủ động trong an ninh mạng — các phát hiện gần đây xác nhận cả phe tấn công lẫn phòng thủ đều đang “tăng lực” nhờ AI. (Forbes, Axios)

- Thực tế: phần lớn tổ chức mới ở mức “thí điểm/cục bộ”; “triển khai đầy đủ” còn thấp do rào cản kỹ thuật, quản trị rủi ro, và thay đổi tổ chức. (EY, CIJ Europe)

Tài liệu tham khảo nhanh

- Forbes tóm lược khảo sát EY về mức độ áp dụng “agentic technology”. (Forbes)

- EY US AI Pulse (bản web + PDF) – số liệu về ROI, mức độ triển khai và trở ngại. (EY)

- NIST AI RMF & bản hướng dẫn GAI Profile. (NIST, NIST Publications)

- ISO/IEC 23894 (AI risk management). (ISO)

- ReAct & Toolformer – nền tảng kỹ thuật cho “reason + act” và “tự học dùng công cụ”. (arXiv)

- Tổng quan thất bại đa-agent & đánh giá năng lực agent. (OpenReview, arXiv)

- MITRE ATLAS – khung đe doạ cho hệ thống AI. (Sysdig)

Nếu bạn muốn, tôi có thể biến checklist trên thành ma trận kiểm soát theo NIST AI RMF cho từng quy trình cụ thể (CS, IT ops, cybersecurity) để triển khai ngay tuần này.