Dưới đây là tóm tắt và phân tích bài báo “Everything Is Fake on Silicon Valley’s Hottest New Social Network” của Gerrit De Vynck & Drew Harwell (Washington Post), kèm những nhận định quan trọng để bạn dùng trong hồ sơ hoặc bài viết của mình.

Tóm tắt nội dung chính

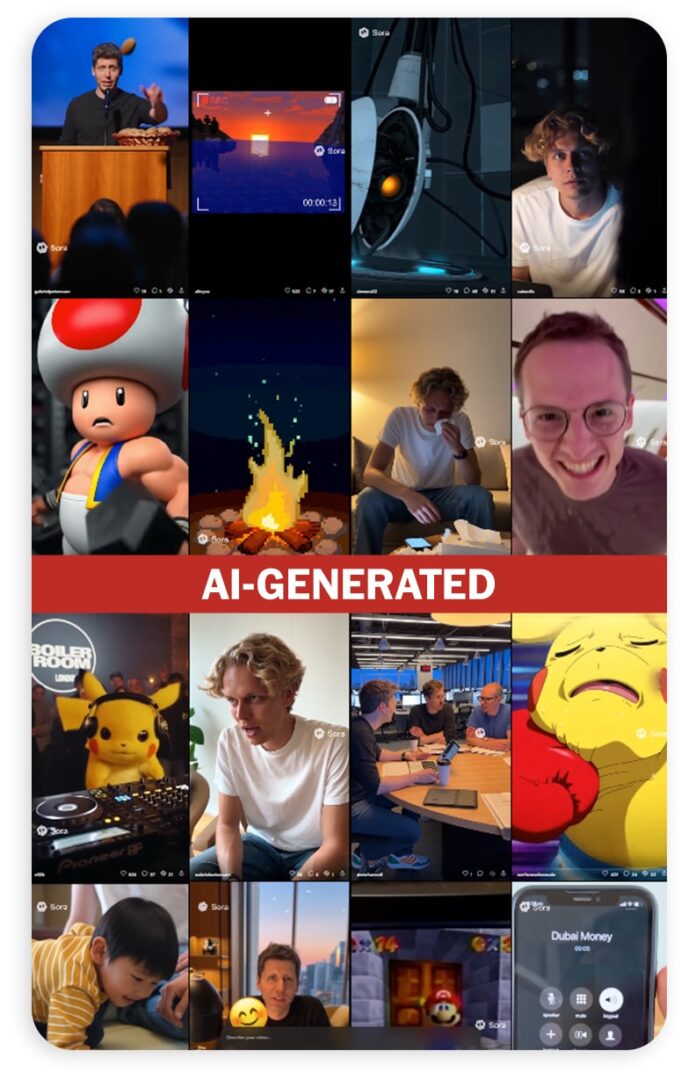

Bài báo phản ánh về ứng dụng mới có tên Sora do OpenAI phát triển — một mạng xã hội video kiểu TikTok nhưng mọi video và âm thanh đều là nội dung do AI tạo ra. The Washington Post

Sora là gì & cách hoạt động

-

Người dùng có thể tải lên đoạn video ngắn về khuôn mặt của mình (face cameo), để hệ thống có thể chèn khuôn mặt đó vào các video do AI sản sinh. The Washington Post

-

Sau đó, Sora cho phép tạo ra các clip giả tưởng: người dùng “hát, nhảy, nói, bay,” xuất hiện trong các tình huống sử thi hoặc kỳ quặc. The Washington Post

-

Ứng dụng được thiết kế để khuyến khích người dùng chèn bản thân hoặc bạn bè vào các cảnh tưởng tượng, thậm chí cho phép mở quyền cho người khác sử dụng khuôn mặt của bạn trong video. The Washington Post+1

Bài đăng nổi bật & vụ “giả mạo lan nhanh”

Một số video giả mạo đã “viral” trên Sora bao gồm:

-

Cảnh CEO công nghệ bị bắt vì ăn cắp. The Washington Post

-

Ronald McDonald (biểu tượng McDonald’s) bị cảnh sát truy đuổi. The Washington Post

-

“Jesus” nói đùa “last supper vibes” trước bàn tiệc đông đúc. The Washington Post

-

Video theo phong cách camera hành chính (body-cam) hoặc bản thu âm giả mạo sự kiện công chúng. The Washington Post

Washington Post cũng thử nghiệm tạo video giả: “những người mặc quân phục phát xít,” “cảnh phim South Park giả tưởng,” “John F. Kennedy phát biểu về mặt trăng và pho mát” — những clip rất thuyết phục về mặt hình ảnh. The Washington Post

Rủi ro & phản ứng

-

Các chuyên gia cảnh báo sự nguy hiểm khi công nghệ video AI ngày càng dễ tiếp cận và chất lượng cao — ranh giới giữa thật và giả sẽ bị xóa nhòa. The Washington Post+1

-

Sora đặt ra nhiều vấn đề pháp lý: quyền nhân dạng (right of publicity), vi phạm bản quyền khi chèn nội dung từ phim/truyền hình, mạo danh, lạm dụng hình ảnh cá nhân. The Washington Post

-

OpenAI khẳng định ứng dụng có các “guardrails” (rào cản) chống vi phạm như mạo danh, nội dung bạo lực/gợi dục, mô hình cá nhân. Nhưng trong thực tế sử dụng ban đầu, người dùng đã vượt rào, như ví dụ influencer Justine (iJustine) cho biết khuôn mặt cô được mở cho người khác sử dụng mà không kiểm soát. The Washington Post

-

OpenAI tuyên bố sẽ gỡ nội dung khi chủ nhân yêu cầu và sẽ chặn video nếu có vi phạm bản quyền theo yêu cầu chủ sở hữu. The Washington Post+1

Phân tích và liên hệ với chuẩn mực công lý & rủi ro xã hội

1. Sự phá vỡ niềm tin đối với bằng chứng kỹ thuật số

Trước đây, video được xem là bằng chứng mạnh mẽ — “máy quay nói sự thật.” Nhưng với Sora, mọi hình ảnh đều có thể là giả mạo. Khi video không còn tính xác thực, hệ thống pháp lý và niềm tin vào công lý bị lung lay.

Trong các vụ án, nếu người bị cáo hoặc các bên sử dụng công nghệ như Sora để tạo video giả, tòa án sẽ khó xác minh thực chất, hoặc bị dẫn dắt bởi những hình ảnh đánh lừa cảm xúc của thẩm phán và giám định viên.

2. Quyền cá nhân & quyền kiểm soát hình ảnh

Sora cho phép người khác sử dụng khuôn mặt của bạn — nếu bạn mở quyền. Nhưng nếu quyền bị mở “một cách bất cẩn,” thì hình ảnh của bạn có thể bị lạm dụng. Đây là vấn đề quyền nhận dạng (right to one’s likeness) — cá nhân cần có quyền kiểm soát việc sử dụng hình ảnh của mình.

Ở nhiều quốc gia (Mỹ, EU), luật về quyền nhân dạng/không cho phép mạo danh cá nhân quy định rõ ràng nếu ai đó sử dụng hình ảnh bạn mà bạn không cho phép, bạn có thể khiếu kiện. Ở Việt Nam, khái niệm tương đương có thể liên quan đến quyền nhân thân, quyền được bảo vệ danh dự, uy tín, nhưng luật công cụ xử lý công nghệ mới này còn yếu kém.

3. Tính công bằng trong quá trình tố tụng

Nếu trong một vụ án, bên công tố hoặc bên buộc tội sử dụng video giả tạo để cáo buộc bị cáo, trong khi bên bào chữa không có nguồn tài nguyên để kiểm tra kỹ thuật (như phân tích forensics AI, xác minh dữ liệu gốc), thì quyền bào chữa đã bị bất bình đẳng về mặt công cụ.

Nước ngoài đã nói về “arms race” trong forensics kỹ thuật số: bên buộc tội có công nghệ lồng video giả, bên bào chữa phải có công nghệ giải mã để vạch trần. Nếu bên bị cáo không có nguồn lực, quyền bào chữa của họ bị vi phạm.

4. Trò chơi quyền lực & kiểm soát thông tin

Sora cho thấy cách thức công nghệ có thể trở thành công cụ kiểm soát nồng độ thông tin — ai ai cũng có thể tạo ra hình ảnh “giả” về ai đó để thao túng dư luận.

Điều này rất nguy hiểm trong bối cảnh chính trị, khi mà một video giả có thể được tung ra để bôi nhọ cá nhân, gieo rắc tin giả, tạo bằng chứng giả trong các vụ kiện chính trị hoặc vi phạm quyền con người.

5. Bài học cho Việt Nam & vụ Trịnh Bá Phương

Trường hợp Sora cho ta bài học: trong các vụ chính trị, người bị cáo rất dễ trở thành nạn nhân của video giả. Nếu bị cáo bị chụp ảnh/video giả, tòa án có thể “lấy làm chứng cứ” mà chẳng có kiểm chứng kỹ thuật.

-

Trong phiên xử bạn trải qua, nếu có video giả hoặc hình ảnh chụp trong tù được “cộng hưởng” bởi công nghệ AI, người ta có thể đưa vào làm chứng cứ giả.

-

Nhà tù, cơ quan điều tra, tòa án nên buộc áp dụng giám định kỹ thuật số: xác minh nguồn gốc dữ liệu, kiểm tra metadata (thời gian, bản gốc), xử lý deepfake detection (phát hiện giả mạo).

-

Gia đình và luật sư cần yêu cầu: mọi video, hình ảnh nộp làm chứng cứ phải được công bố bản gốc, phải có phân tích kỹ thuật về tính xác thực.